在信息爆炸的当下,要想迅速且精确地搜集到大量信息,就能在竞争中抢占先机。但数据搜集并非轻而易举,只有掌握了关键技巧,才能达到事半功倍的效果。下面,我将为大家详细阐述。

数据抓取原理

数据抓取是获取信息的关键途径,其核心是通过模仿用户在网上的行为,从网站或其他数据来源中搜集信息。网络爬虫是完成这一工作的主要工具,它如同一个不知劳累的小信使,依照既定规则,在互联网上自动游走,收集所需数据。掌握这一原理,便是打开数据抓取之门的钥匙。

API接口优势

API接口是获取即时信息的有效方法。众多平台均会提供此类接口,借助它,用户可以迅速且精确地获取所需数据。比如,某新闻网站的API,便能让开发者迅速掌握资讯。通过使用API接口,开发者无需进行繁琐的网页解析,从而省了大量时间和精力,使得数据获取过程变得更加简便。

确定数据源

确定数据源是数据抓取工作的第一步。需明确所需数据的具体来源,这可能是单个网站,也可能是多个平台的组合。以电商数据分析为例,需要选择知名的电商平台作为数据来源。只有确定了目标数据源,才能有针对性地进行后续工作,从而提升数据抓取的效率。

分析网页结构

![图片[1]-掌握数据抓取核心技巧,轻松获取海量数据的必备方法-东山笔记](http://83ch.com/3.png)

网页的布局决定了信息的储存与展示形式。不同的网站,它们的代码架构和数据分布各不相同。通过研究网页的布局,我们能够掌握数据的存放位置和格式。以一个论坛为例,帖子的标题、内容等关键信息都由特定的HTML标签所包含,对这些标签的准确分析,有助于我们精确地提取所需的数据。

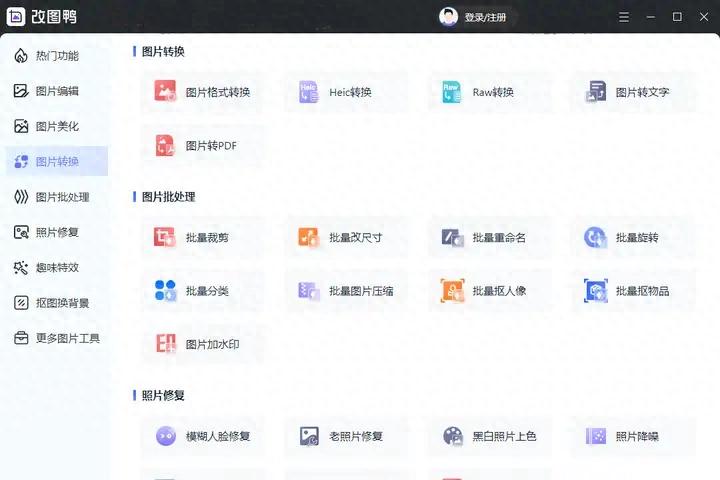

选择爬虫工具

挑选恰当的爬虫软件十分关键。目前市场上存在众多出色的爬虫架构,比如Scrapy。Scrapy功能全面,运行高效且稳定,非常适合进行大量数据的抓取。依据不同的任务和具体情境,挑选最匹配的工具,可以使数据采集过程更加高效,事半功倍。

设置爬虫参数

确保数据质量的关键在于设置合适的爬虫参数,这些参数涵盖了抓取的频率以及数据的存储方式。恰当的抓取频率既能减轻目标网站的负担,又能降低被封禁的风险。同时,选择合适的数据存储格式,比如CSV或JSON,将有助于后续的数据处理和分析工作。

掌握了这些数据提取的关键方法,相信你能够轻松地收集到大量的信息。然而,在实际执行过程中,你可能会觉得哪个环最为棘手?别忘了点赞并转发这篇文章,让更多的人能够从数据提取技巧中受益。