![图片[1]-拆解logstash:免费开源的日志分析和数据收集工具介绍-东山笔记](https://83ch.com/wp-content/uploads/2025/05/1746337791679_0.png)

在当今时代,数据呈现出磅礴的爆发之势,有一款开源的数据收集引擎,具备非凡的能力,能助力人们高效处理数据,它究竟有何神奇之处,让我们深入探究一下 。

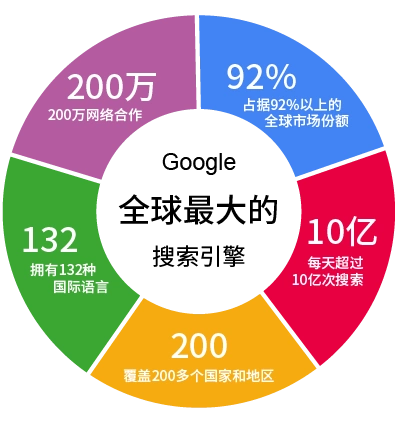

强大功能概述

这款开源的数据收集引擎功能多样,可实现实时数据传输,能进行数据解析,能够完成数据转换,还可以实现数据存储。它具备强大的过滤器,拥有插件,有多样的输出选项,这使得它能轻松与不同系统集成,能轻易和不同服务集成,就如同一个万能的数据连接器,可让数据在不同环境中顺畅流动。

数据采集能力

它能够从各类不同的数据源收集数据,这些数据源包括文件、网络以及数据库等 。不管是本地文件里的数据 ,还是远程网络传来的数据 ,又或是数据库中存储的数据 ,它都可以精确收集 ,并把这些数据传输到指定的目标 ,以此为后续的数据处理做好准备 。

![图片[2]-拆解logstash:免费开源的日志分析和数据收集工具介绍-东山笔记](https://83ch.com/wp-content/uploads/2025/05/1746337791679_1.png)

解析转换本领

它的解析功能很强大,它的转换功能也很强大。现在的数据结构复杂多样,它能够把这些复杂的数据拆分成可以操作的元素,它还能将数据从一种格式转换为另一种格式,这样方便不同系统处理和利用数据,极大地提升了数据的通用性和可用性。

过滤数据优势

![图片[3]-拆解logstash:免费开源的日志分析和数据收集工具介绍-东山笔记](http://83ch.com/13.png)

借助过滤器插件,可对数据开展筛选工作,还能进行修改,或者予以增强。例如能够提取特定的字段,能够删除无用的数据,能够替换特殊字符等。这如同给数据做了一回精细的“体检”,又做了一次“美容”,使得数据变得更加精准且有用。

多样输出方式

它支持多种输出插件,能够把处理好的数据发送到不同目标。这些目标包括文件、数据库、消息队列以及远程服务器,它都可以准确送达,从而满足不同场景的数据输出需求。

使用基本步骤

gpg --keyserver hkp://keys.gnupg.net --recv-keys 409B6B1796C275462A1703113804BB82D39DC0E3

curl -sSL https://get.rvm.io | bash -s stable --ruby=$(cat .ruby-version)

使用该引擎传输和处理日志、事件或其他数据存在一套基本步骤,首先需从官网下载适合自身操作系统的安装包并完成安装,接着配置输入插件,依据实际情况选择从文件或者远程服务器接收日志,然后配置过滤器插件,对日志数据开展处理转换,最后配置输出插件,把处理后的数据发送到目标系统。之后开展测试,查看能否成功收集数据,能否成功处理数据。还能够借助多线程等办法提升数据处理速度。最后和ELK集成,经由Kibana直观剖析并可视化日志数据。

要是大家用这款开源数据收集引擎时,碰到和其他系统集成有困难的状况,你们会采取啥办法解决?不妨给本文点赞、分享,然后在评论区讲讲你的想法。

$ ruby -v

export OSS=true