想要轻松获取C/C++教师岗位的相关资讯吗?或许不少朋友对此感到有些困惑。今天,我们将动手进行一个简单的项目实践,并详尽地为大家讲解如何实现这一目标!

![图片[1]-什么是爬虫?能用来做什么?教你开发爬虫项目爬取信息-东山笔记](https://83ch.com/wp-content/uploads/2025/06/1749211936371_0.jpg)

安装IDE

选用可视化集成开发环境,弃用内置解释器,主要考虑其操作界面的顺畅度,还有那众多实用且丰富的功能。此外,安装过程十分简便,只需在软件界面上依次点击“文件”、“新建项目”、“输入项目名称”,然后“选择添加符号”、“填写相关信息”,再“点击左下角的操作按钮”,稍等片刻,系统便会自动完成安装,并显示成功提示。若在安装过程中遇到难题,可以尝试通过私信寻求技术支持。

爬虫流程

![图片[2]-什么是爬虫?能用来做什么?教你开发爬虫项目爬取信息-东山笔记](https://83ch.com/wp-content/uploads/2025/06/1749211936371_1.jpg)

爬虫需要将待发送的URL信息传递给调度系统,这一过程需要手动编写程序代码来实现。调度系统在收到URL信息后,会将其转交给下载中间件进行后续处理。在这个过程中,是否使用代理服务器(例如Proxy代理)是一个可选的操作。下载器完成数据处理后,会提取所需数据,并通过管道将其传输到指定的存储位置。与此同时,新提取的URL可被重新输入调度系统,用于后续处理步骤。若没有URL请求,程序将自动停止运行。

创建项目

![图片[3]-什么是爬虫?能用来做什么?教你开发爬虫项目爬取信息-东山笔记](http://83ch.com/46.png)

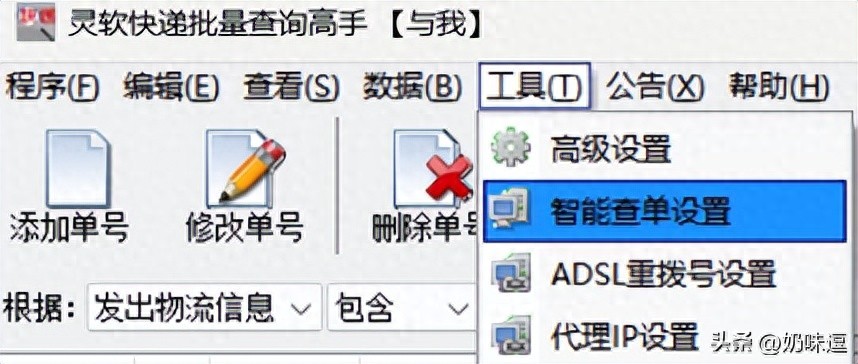

在命令行界面创建项目时,系统会自动添加相应的文件和配置选项;进入项目后,系统会自动生成一系列文件。蜘蛛目录是专门用来存放爬虫程序文件的,也是开发爬虫任务时指定的存放位置;在items.py这个文件里,我们设定了需要抓取的数据字段;而pipelines.py文件,则是用来存放筛选后的数据;至于settings.py文件,它是Scrapy框架的配置文件,在这里我们可以对各种参数进行调整和设置。

创建爬虫文件

建立爬虫文件主要有两种途径。首先,我们可以在命令行界面输入“scrapy genspider”这一命令,接着输入“-t basic”这个选项。为确保爬虫启动后能准确辨认,我们需选用此名称。此外,在spiders文件夹中,还需创建一个新文件。通常情况下,多数人倾向于选择第一种方法,我亦能帮助您完成相关代码编写。

编写爬虫代码

在开发爬虫程序时,我们通常会对网页上的不同元素及其对应变量进行关联。为了提升爬虫脚本的执行效率,我们得先确定目标网站的网址,接着运用xpath技术来提取所需的数据字段。之后,我们可以创建一个item对象,并将其提交到Scrapy框架进行处理。在网页文本信息的提取环,我们能够使用如info = response.xpath(“./p/text()”).get()这样的代码片段。与此同时,我们还可以利用f.write()函数,将所获取的数据有效地记录到文件中。

启动爬虫与保存数据

打开管道文件,同时确保注释功能已激活,接着执行 scrapy crawl 指令。这个名称是系统自动生成的,另外,您还可以手动建立一个叫作start.py的文件,该文件用于引入与命令行操作有关的库。请记住,这个start.py文件需要和scrapy.cfg文件存放在同一个文件夹中。完成这些步骤后,所有通过爬取获取的数据将被自动保存在一个json格式的文件中。

在编写爬虫过程中,你是否遇到过特别棘手的难题?别忘了为这篇文章点赞和转发。