大数据对我们日常生活的各个方面以及工作领域都带来了重大的改变,对于了解其搜集手段的重要性不言而喻。你是否明白大数据究竟是如何被收集的?下面,我将详细地为大家讲解这个过程。

基本框架概述

大数据采集的基础结构由六个关键部分构成,其中,网站页面模块承担着抓取网页内容的重要职责,它犹如一位精通信息搜集的行家,在众多网站上搜集文字、图片等资料。而链接抽取模块则能够从网页内容中精准地筛选出正文内容的链接地址,这就像在广阔无垠的大海中寻宝,能够精确地锁定关键位置。这些数据里涵盖了网站的网址、抓取数据的网页网址和具体内容,仿佛是一座蕴藏着丰富宝藏的数据仓库。

链接过滤作用

链接筛选功能至关重要,判断网页链接所指向的信息是否已被收录。在众多网页链接中,过滤模块充当着严格的守门员。一旦某网页信息已被收录,再次抓取就变得毫无意义。通过运用过滤机制,我们能够有效减少不必要的重复工作,提高数据收集的效率,保证资源得到合理利用。

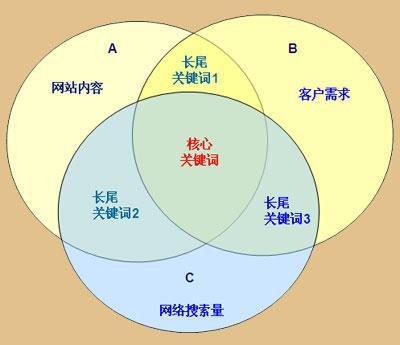

内容抽取要点

在网页上抓取特定的资料是内容提取的核心目标,以电商平台为例,消费者一般只关注商品的价格、销量等核心特征。这时,内容提取的功能就像是一台精准的吸尘器,将这些关键信息准确搜集。而且,它还非常重视数据的准确性,确保提取的信息真实可靠,从而保障后续的分析和处理能基于可靠的数据进行。

爬取队列机制

![图片[1]-互联网大数据采集流程:如何获取及处理相关网页内容?-东山笔记](http://83ch.com/52.png)

爬虫要抓取数据的网站地址被加入了队列。这个队列就像一个有序的任务清单,爬虫会按照这个清单逐一执行任务。它能合理安排抓取的顺序,根据重要性和抓取频率等标准,对地址进行排序,保证爬虫在收集不同网站信息时,既能高效进行,又不会遗漏或出现混乱。

基本步骤流程

大数据采集的步骤是明确设定的。首先,我们将目标网站的网址资料输入到URL队列中,这就像在规划一次旅行,首先要确定要去的目的地。随后,爬虫程序会从队列中提取这些网址资料,并开始抓取网页内容。然后,我们会从正文页面中提取链接地址,进行URL的筛选,再将筛选出的结果与已抓取的网址进行对比。整个流程井然有序,每一步都为后续步骤打下了坚实的基础。

未来发展趋势

大数据的发展值得关注,特别是它在数据收集领域的应用。随着技术的不断进步,数据收集的效率有望得到提高,同时准确度也可能得到增强。众多新颖的算法和工具的出现,预示着数据收集将变得更加智能化和自动化。但这也可能引发安全和隐私方面的挑战。在数据收集过程中,如何确保用户的隐私和信息安全,将成为未来我们重点关注和解决的问题。

你对大数据的搜集环已有了解,那么我想知道,你预计在哪个行业或领域内,大数据的搜集将展现出最为显著的进展?期待你能点赞、转发这篇文章,并留下你宝贵的看法。