在互联网迅猛发展的今天,数据已成为企业和个人争夺竞争优势的核心要素。然而,数据收集与处理面临诸多挑战。别忧心,一款专门的数据采集与自动上传的网站工具能够助你轻松克服这些难题。

工具基本情况

这款工具专门针对某种语言设计,用于自动化收集、处理和传输数据。它包括数据采集、处理和上传三个主要部分。在数据采集环,它能够抓取目标网站的文本和图片等资料,例如电商平台的商品详情等。接下来,数据处理环负责对收集到的信息进行清洗和加工,使数据变得更加有序。最终,数据上传环将这些处理后的数据传输到目标网站,确保数据能够被有效转移。

数据采集模块使用

操作简便,只需在命令行中输入特定指令,即可激活数据采集功能。指令输入完毕,系统便会自动进行目标网站的抓取。此外,用户还可对配置文件进行编辑,例如调整目标网页链接,从A网站切换至B网站;或更改抓取内容种类,从仅抓取文字扩展到同时抓取图片。通过这些操作,用户可以灵活获取所需数据。

python data_crawler.py

数据处理模块使用

采集完毕后,我们将获得原始数据。为了更高效地使用这些数据,我们需要对其进行清洗和加工。在命令行中输入相应指令,即可启动数据处理模块。该模块将自动对原始数据进行操作。你还可以在配置文件中对清洗规则进行调整,例如删除重复的数据;或者修改加工方式,对数据进行分类和汇总。通过这些步骤,我们可以提升数据的价值。

数据上传模块使用

python data_processing.py

完成数据处理后,需将数据上传至指定网站。在命令行中输入相应指令,即可激活数据上传功能,该模块将自动执行上传任务。此外,用户还可对配置文件进行编辑,例如,调整上传模式,实现从单条数据上传到批量上传的转变;或修改目标网站地址,以便将数据上传至其他网站。

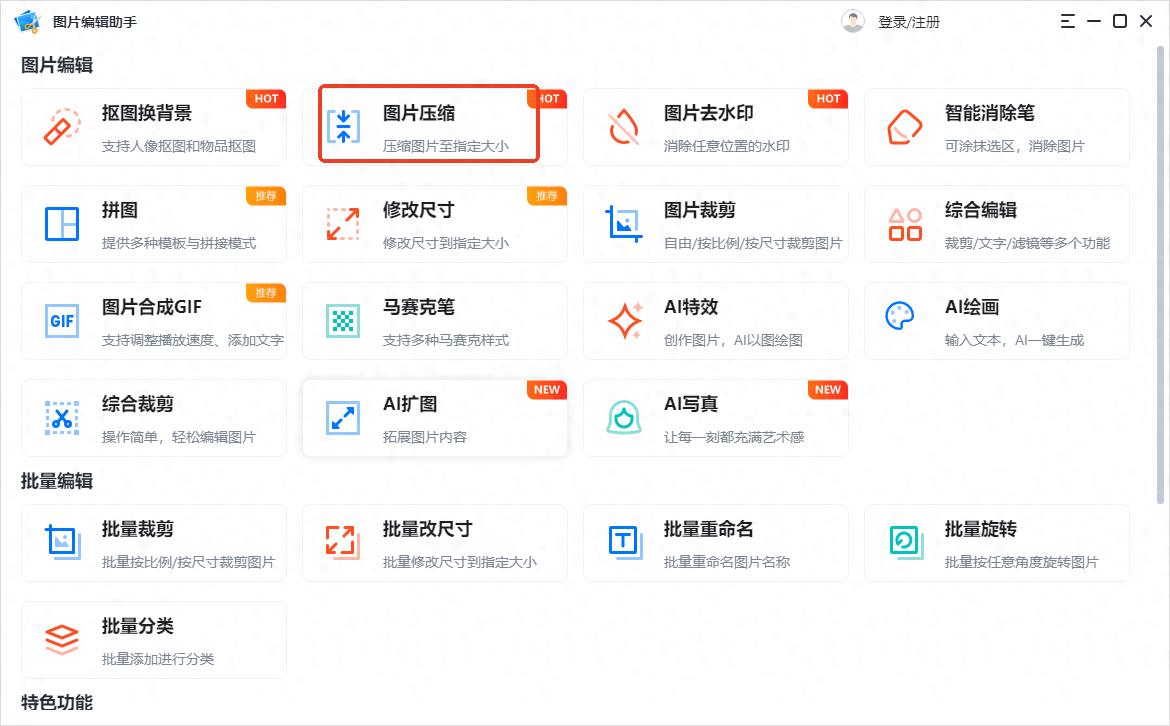

![图片[2]-互联网时代数据成竞争关键,这款工具助你轻松采集处理上传数据-东山笔记](https://83ch.com/wp-content/uploads/2025/07/1753852855195_1.jpg)

工具显著优势

首先,自动化技术实现了数据采集、处理和上传的全程自动化,这显著提升了工作效率。过去,人工操作可能需要数天时间,而现在使用这项技术,几个小时就能完成,而且准确性也更高。其次,灵活性方面,配置文件可以灵活调整,能够满足各种不同的需求。无论是小网站的数据采集,还是大型平台的数据处理,都能轻松应对。第三点,它的可扩展性很强,依托于特定的语言进行开发,便于后续的二次开发与拓展,能够满足更加复杂的需求。

工具应用前景

在当前这个数据竞争日益激烈的年代,这款工具展现出了广阔的发展空间。企业能够借助它搜集市场信息,洞察消费者需求,进而制定有效的营销计划。而对于个人来说,它同样适用于学术研究、兴趣爱好数据的搜集等。有了这款工具,处理数据变得不再复杂。

python data_upload.py

各位朋友,在你们进行数据收集和加工的过程中,有没有遇到过什么棘手的问题?你们认为这款软件能否帮助你们解决这些问题?不妨点个赞,把这篇文章分享出去,让我们来交流一下数据处理的技巧!