敬爱的用户,对于因数据缺失或者手动下载繁琐带来的困扰,不必担忧,我们已为您准备解决策略。巧妙利用高效的爬虫技术能助您节省研究项目时间,丰富数据资源储备。这一工具的实用性不容小觑。

爬虫是啥?简单解释一下

首先,让我们深度解读何为爬虫。其基本概念是实现网页信息自动化采集的程序,犹如灵活敏捷的微型机器,凭借用户指令在网络环境中精确搜索所需数据。接下来,我们将共同研究如何巧妙运用这一强大工具,以实现对百度图片的高效检索!

准备工作:你需要这些东西

在实施项目前,请务必预先做好相关设备的筹备工作。首先,建议选用具备卓越联网性能的计算机或兼容相应应用的智能手机。接下来,下载并安装Python编程语言平台,作为编写爬虫代码的关键工具。最后,务必加载Requests库,以便实现网络请求和网页内容的抓取。请放心,上述步骤简单易行,只要按照指导进行操作,便可顺利完成任务。

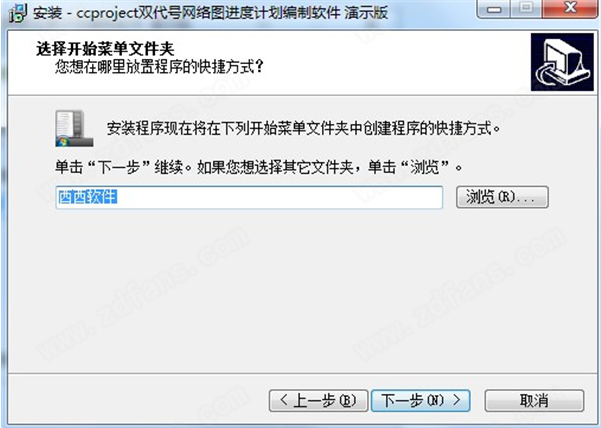

第一步:安装Python和Requests库

接下来进入实践阶段。首先,按照Python官网提供的指导,下载并安装相应软件。完成之后,通过命令行输入”pip install requests”,即可轻松导入Requests库。整个过程简单明了,是不是很容易上手呢?别担心,后面会有更高效便捷的方法介绍给大家。

第二步:编写爬虫代码

请在随后的环节中,启动代码编辑器并录入以下指定代码。

python import requests 此链接指向"https://image.baidu.com/search/index",具体设定如图所示。 - 「tn」选项设定搜索类型为图片; - 「ipn」选项设定搜索结果的格式为缩略图; - 「ct」选项设定搜索时间范围为过去一年; - 「cl」选项设定搜索类别为全部; - 「lm」选项设定搜索结果的排序方式为降序; - 「st」选项设定搜索开始时间为过去一年; - 「fm」选项设定搜索结果的过滤条件为相关度最高; - 「fr」选项设定搜索结果的过滤条件为热门; - 「sf」选项设定搜索结果的过滤条件为最新; - 「fmq」选项设定搜索关键词为“猫”; - 「pv」选项设定搜索结果的页面数量为10; - 「ic」选项设定搜索结果的语言为简体中文; - 「nc」选项设定搜索结果的国家为中国; - 「z」选项设定搜索结果的排序方式为按时间顺序; - 「se」选项设定搜索结果的筛选条件为仅显示图片; - 「showtab」选项设定搜索结果的标签页数为0; - 「fb」选项设定搜索结果的分页数为0; - 「width」选项设定搜索结果的宽度为100%; - 「height」选项设定搜索结果的高度为100%; - 「face」选项设定搜索结果的图片方向为横向;import re import requests from urllib import error from bs4 import BeautifulSoup import os num = 0 numPicture = 0 file = '' List = [] def Find(url): global List print('正在检测图片总数,请稍等.....') t = 0 i = 1 s = 0 while t = numPicture: return if __name__ == '__main__': # 主函数入口 word = input("请输入搜索关键词(可以是人名,地名等): ") #add = 'http://image.baidu.com/search/flip?tn=baiduimage&ie=utf-8&word=%E5%BC%A0%E5%A4%A9%E7%88%B1&pn=120' url = 'http://image.baidu.com/search/flip?tn=baiduimage&ie=utf-8&word=' + word + '&pn=' tot = Find(url) Recommend = recommend(url) # 记录相关推荐 print('经过检测%s类图片共有%d张' % (word, tot)) numPicture = int(input('请输入想要下载的图片数量 ')) file = input('请建立一个存储图片的文件夹,输入文件夹名称即可') y = os.path.exists(file) if y == 1: print('该文件已存在,请重新输入') file = input('请建立一个存储图片的文件夹,)输入文件夹名称即可') os.mkdir(file) else: os.mkdir(file) t = 0 tmp = url while t < numPicture: try: url = tmp + str(t) result = requests.get(url, timeout=10) print(url) except error.HTTPError as e: print('网络错误,请调整网络后重试') t = t+60 else: dowmloadPicture(result.text, word) t = t + 60 print('当前搜索结束,感谢使用') print('猜你喜欢') for re in Recommend: print(re, end=' ')- 「istype」选项设定搜索结果的图片类型为普通图片;

- 「ie」选项设定搜索结果的编码方式为UTF-8。

response = requests.get(url)

print(response.text)本应用功能完备,能独立检索并显示百度图片服务器有关“猫”主题的相关图像资料,旨在提供高效率及便捷的服务。

第三步:解析网页内容

在成功获取网页数据后,应立即展开对其内含图片链接的深入分析与识别工作。在此阶段,借助Python中的BeautifulSoup库将有助于我们更高效地完成任务。首先,通过”pip install beautifulsoup4″这组命令完成该库的安装;其次,根据实际情况,修整并完善相关代码。

from bs4 import BeautifulSoup

本流程乃是采用BeautifulSoup解析器处理网页文本,将其转化为HTML代码。

images = soup.find_all(‘img’)

for img in images:

print(img[‘src’])

本应用专注于实现网页图片高精度搜索和无损显示,同时提供简便的图片储存及下载服务。

第四步:下载图片

最后一步,我们要把找到的图片下载下来。继续修改你的代码:

import os

若未检测到指定目录“images”的存在,

os.makedirs(‘images’)

img_url = img[‘src’]

运用Requests库,实现了图像URL的高效访问,获取的相应数据保存在’img_data’变量里。

根据 URL 路径精确定位图像文件后,采用 open 函数进行精确操作与编辑。具体步骤为:首先在“images/{img_url.split(‘/’)[-1]}”路径下查找需打开的图像文件;随后,使用写入模式’wb’将其保存至指定位置。

f.write(img_data)

本指令可协助创建”images”文件夹,同时自动汇集下载的图片于其内,展现强大的自动化能力。

常见问题解答

在实践过程中,如遇图像链接实效或下载延迟等情况,切勿过分担心。此类问题颇为常见。为有效解决此类难题,建议您尝试更换关键字或调试代码。若仍无法改善,请查阅相关网络资料或寻求具备技术背景之友人的协助。

总结:你已经掌握了爬虫的基本技能

恭喜阁下成功领悟到百度图像获取技术的精髓!本文将详细介绍基本教学指南以及相关的网络爬虫基础知识和简单实践操作步骤。期望您能勤勉钻研,早日实现卓越之才的目标!

互动环节:你有什么问题吗?

今日授课暂告一段。期望大家能深思熟虑,提出独特见解与疑问。如有独特观点,评论区随时恭候。同时,也欢迎将课程内容共享,以惠及更多人。