GPT-3究竟有多厉害?它拥有1750亿个参数,能够完成多种自然语言处理任务,实力非凡,让我们一起深入了解

强大的模型地位

GPT-3作为GPT系列中的第三代模型,一经研发并推出,便迅速崭露头角,成为当前最大、最强大的自然语言处理模型之一。在自然语言处理这一领域,GPT-3的地位至关重要,吸引了众多科研人员及企业的广泛关注。众多科技公司纷纷对其研发技术进行研究与应用,持续推动自然语言处理领域的边界不断拓展。

在影响力方面,它颠覆了大众对自然语言处理模型能力的看法。过去,模型在应对复杂任务时往往显得力不从心,然而GPT-3凭借其卓越的性能,打破了这一局限,使更多的人意识到了该领域所蕴含的巨大潜力。

广泛的使用场景

GPT-3的应用领域十分广泛,能够胜任众多自然语言处理工作。在文本创作领域,它能够迅速生成故事、新闻稿等多种形式的文本。举例来说,许多自媒体从业者会利用它来激发创作灵感。

在机器翻译这一领域,GPT-3展现出卓越的跨语言翻译能力。对于跨国公司来说,在处理文件资料的翻译工作时,运用GPT-3能够显著减少所需的时间和人力投入。此外,在对话生成和摘要生成等任务上,GPT-3同样表现出色,有效提升了工作效率。

独特的预训练策略

GPT-3运用了一种既高效又大规模的无监督预训练方法。这一过程主要分为两个阶段,首先,它利用单一语言的预训练数据,通过自回归的架构进行训练。这样的方法使得模型能够深入掌握大量文本数据中的语言规则。

将众多文本资料输入模型,这相当于为其积累了丰富的知识库。在这一过程中,模型持续进行自我完善,因此在后续执行各类自然语言处理任务时,它表现得更加熟练,并能迅速而精确地提供答案。

自回归语言建模方式

![图片[1]-GPT-3模型原理大揭秘!GPT2中文生成教程也在这儿了-东山笔记](http://83ch.com/5.png)

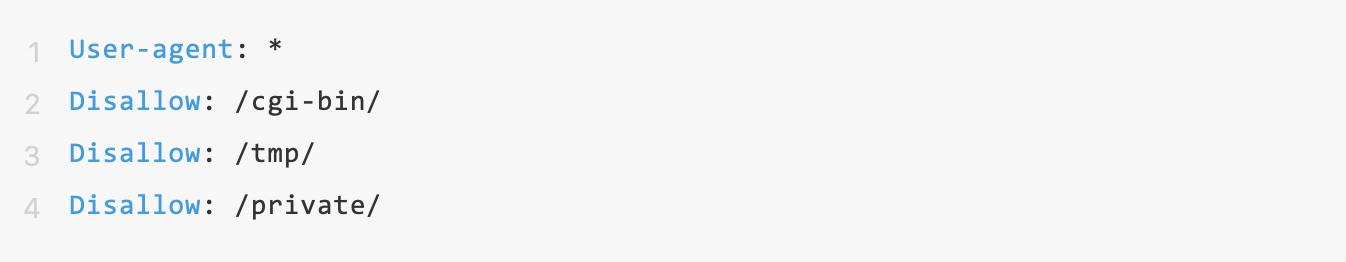

在处理指定的输入序列时,GPT-3会运用自回归模型来预测紧随其后的单词。这一过程中,序列信息会在每个时间点上被多层编码器逐一解析。随后,通过特定的函数,计算出每个单词出现的概率。

模型在输出时会优先选取概率最高的词汇,这一操作会持续进行。通过这种方式,模型在构建文本时展现出了一定的逻辑性和连续性。比如在撰写故事时,它能够依据前面的内容,合理地推断出接下来的情,并产出流畅自然的文字。

先进的模型结构设计

GPT-3采用的编码器架构中,整合了多头注意力以及残差连接两种技术。多头注意力机制有助于模型集中关注输入序列中的关键信息,从而提升处理速度与准确度。

残差连接技术使得模型在提取特征的过程中能够保留之前的信息,这提升了模型的泛化水平。在应对各种自然语言处理任务时,模型能够更有效地适应和应对,减少了局限性的问题。

出色的学习能力表现

GPT-3具备出色的zero-shot和few-shot学习技能。面对未曾见过的任务,它只需少量样本就能进行有效计算,展现出卓越的执行能力。以自然语言推理测试为例,其表现几乎与专为该任务设计的模型相当。

这得益于它在预训练阶段积累了众多自然语言处理的基本要素。即便遇到全新的挑战,它也能迅速运用所学知识,展现出卓越的适应能力。

pip install transformers

阅读完这篇文章后,你觉得GPT-3会在哪个行业展现出它最大的潜力?不妨在评论区留下你的看法,同时别忘了给我们点个赞,并将这篇文章转发出去!