上个月新发布的AI模型GPT-2受到了广泛关注。该模型参数量高达15亿,其卓越功能令人咋舌。然而,它也引发了一些争议。接下来,我们将对这个模型进行深入分析。

强大参数与训练规模

GPT-2模型的参数量达到了15亿,这个数字确实令人惊叹。研究该模型的负责人Dario表示,这个模型是在一个拥有大约1000万篇文章的数据集上经过训练的。这个数据集的规模比之前最先进的AI模型所使用的数据集大出了12倍,而整体规模更是增加了15倍。这样庞大的训练规模,为该模型的高效表现打下了坚实的基础。参数数量的显著提升,加之大规模数据集的运用,使得GPT-2的学习能力相较于其他模型有了明显的优势。

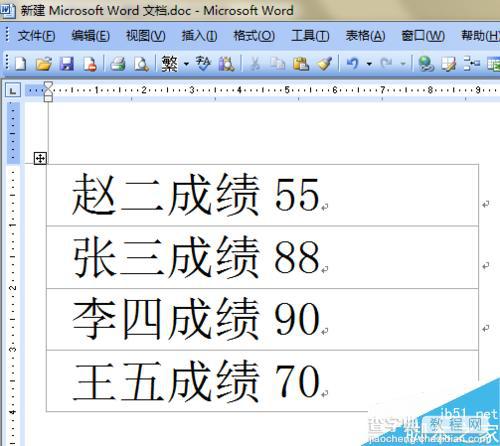

神奇的文本创作能力

研究表明,在安第斯山脉的隐蔽山谷里,有一群独角兽选择隐居,而这个山谷至今尚无人探访。令人感到意外的是,这些独角兽居然能说一口标准的英语。报告中详细记载了独角兽的发现过程,同时列举了专家们对独角兽为何出现在此的讨论,甚至还提到了通过DNA检测来确认它们是否为外星生物的方法。这种严谨的叙述方式,很容易让人对其产生信任。

语言建模的优秀表现

在众多专业领域的语言建模测试中,GPT-2的表现格外出色,成绩相当出色。尽管它未曾针对特定领域的数据进行过特别训练,但它的表现仍旧超越了那些专门针对特定数据集进行优化的模型。博客上所展示的案例更是充分证明了它在语言建模领域的非凡实力,这也难怪它能够吸引众多目光。

![图片[1]-OpenAI发布逆天GPT2模型,一句话竟能编出一篇文章?-东山笔记](https://83ch.com/wp-content/uploads/2025/06/1750147938770_0.jpg)

多任务的卓越成绩

![图片[2]-OpenAI发布逆天GPT2模型,一句话竟能编出一篇文章?-东山笔记](http://83ch.com/59.png)

GPT-2不仅在语言建模方面有应用,还广泛用于问答、阅读理解、摘要生成、翻译等多个领域,并取得了显著成效。博客中展示了相关示例,让人们能直观感受到其强大功能。它在各种任务类型中都表现出色,这进一步扩大了其应用范围,预示着它未来有着广阔的发展空间。

编程学习能力

![图片[3]-OpenAI发布逆天GPT2模型,一句话竟能编出一篇文章?-东山笔记](https://83ch.com/wp-content/uploads/2025/06/1750147938770_2.jpg)

GPT-2掌握了PHP等多种编程语言的语法。它所创作的代码一经展示,即便是AI研究院的Tim Rocktäschel也对其中存在的问题之严重性感到震惊。尽管有人认为其代码不够规范,可能会引起js、C++等语言之间的混淆,但无论如何,它在编程领域的学习成果都令人叹为观止。

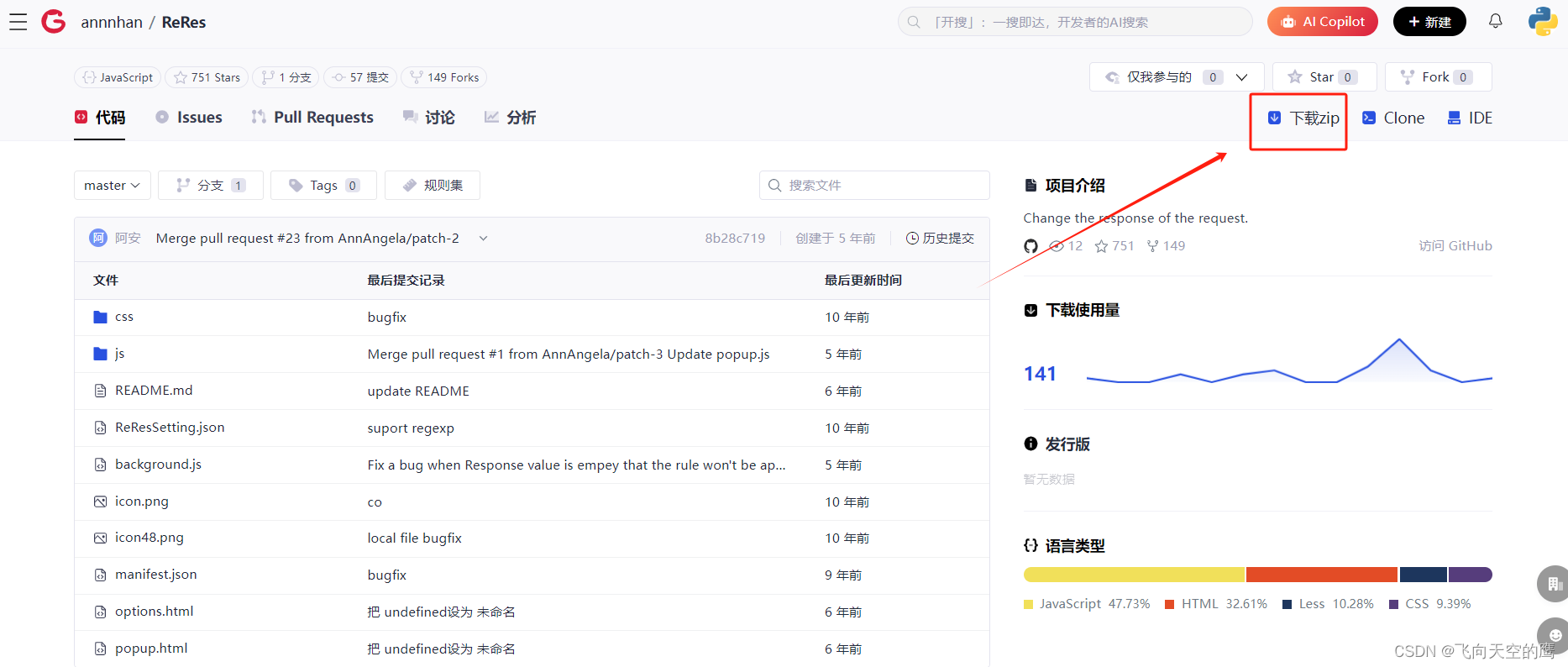

模型未全部发布原因

GPT-2在GitHub上收获了4116个Star和674个Fork的关注。然而,OpenAI的研究团队却选择了不公开该模型训练所需的数据和最大模型预训练后的参数。他们担心,这样强大的模型可能会被不当使用。这一决定也引起了广泛的争议。关于OpenAI决定不对这些数据与参数进行公开,您持何种观点?

![图片[4]-OpenAI发布逆天GPT2模型,一句话竟能编出一篇文章?-东山笔记](https://83ch.com/wp-content/uploads/2025/06/1750147938770_3.jpg)